이번에는 Retrieve fine-tune 에 대해서 살펴 보겠습니다

(2) Retrieve fine-tune

| 제목 | 내용 | 설명 |

| Request | GET https://api.openai.com/v1/fine-tunes/{fine_tune_id} | Gets info about the fine-tune job. |

| Parameters | fint_tune_id (string / 필수) | The ID of the fine-tune job |

Request 샘플과 response 값을 살펴 보겠습니다.

| Request | curl https://api.openai.com/v1/fine-tunes/ft-AF1WoRqd3aJAHsqc9NY7iL8F \ -H “Authorization: Bearer $OPENAI_API_KEY” |

| Response | { “id”: “ft-AF1WoRqd3aJAHsqc9NY7iL8F”, “object”: “fine-tune”, “model”: “curie”, “created_at”: 1614807352, “events”: [ { “object”: “fine-tune-event”, “created_at”: 1614807352, “level”: “info”, “message”: “Job enqueued. Waiting for jobs ahead to complete. Queue number: 0.” }, { “object”: “fine-tune-event”, “created_at”: 1614807356, “level”: “info”, “message”: “Job started.” }, { “object”: “fine-tune-event”, “created_at”: 1614807861, “level”: “info”, “message”: “Uploaded snapshot: curie:ft-acmeco-2021-03-03-21-44-20.” }, { “object”: “fine-tune-event”, “created_at”: 1614807864, “level”: “info”, “message”: “Uploaded result files: file-QQm6ZpqdNwAaVC3aSz5sWwLT.” }, { “object”: “fine-tune-event”, “created_at”: 1614807864, “level”: “info”, “message”: “Job succeeded.” } ], “fine_tuned_model”: “curie:ft-acmeco-2021-03-03-21-44-20”, “hyperparams”: { “batch_size”: 4, “learning_rate_multiplier”: 0.1, “n_epochs”: 4, “prompt_loss_weight”: 0.1, }, “organization_id”: “org-…”, “result_files”: [ { “id”: “file-QQm6ZpqdNwAaVC3aSz5sWwLT”, “object”: “file”, “bytes”: 81509, “created_at”: 1614807863, “filename”: “compiled_results.csv”, “purpose”: “fine-tune-results” } ], “status”: “succeeded”, “validation_files”: [], “training_files”: [ { “id”: “file-XGinujblHPwGLSztz8cPS8XY”, “object”: “file”, “bytes”: 1547276, “created_at”: 1610062281, “filename”: “my-data-train.jsonl”, “purpose”: “fine-tune-train” } ], “updated_at”: 1614807865, } |

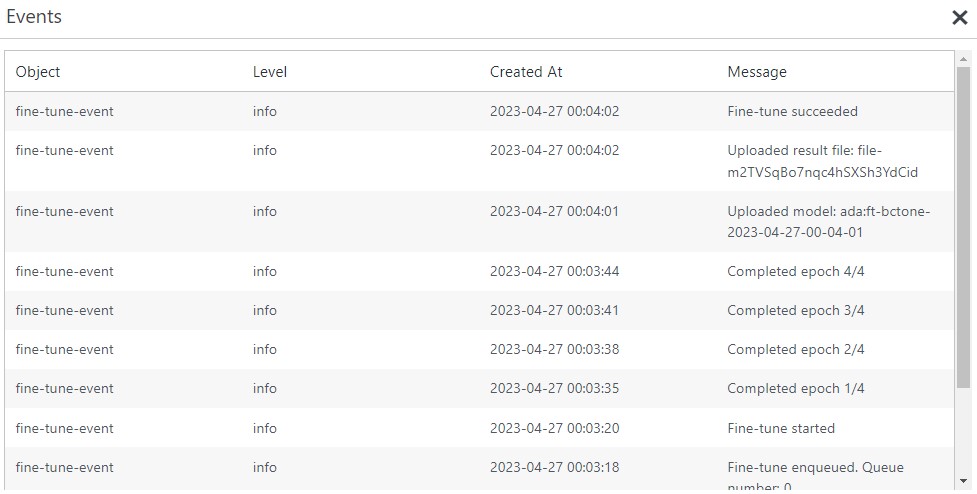

Response 중 진행된 [Events] 값을 출력해 보면 다음과 같습니다.

Fine-tune 시작 일시(2023-04-27 00:03:20)부터 Fine-tune succeeded(2023-04-27 00:04:02)까지 약 40초 가량 되는 것 같네요. 물론 업로드 데이터 size도 얼마되지 않았습니다.

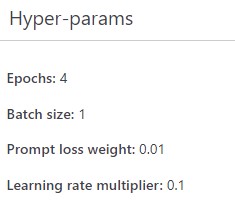

Training에 사용된 기본 Hyper-params 값을 살펴보면 다음과 같습니다.

기본값으로 Epoch 4, 배치 1, loss weight 0.01, learning rate multiplier 0.1이 설정된 것을 확인할 수 있습니다.

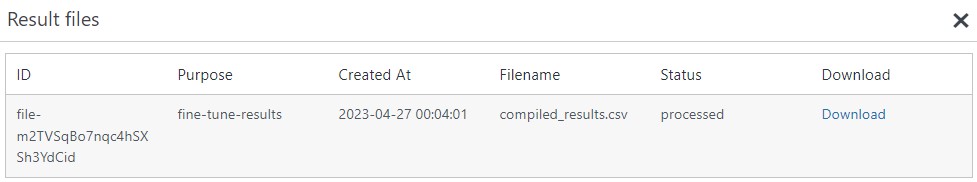

결과 값을 살펴 보겠습니다.

파일 ID, Purpose, 파일 생성 일시, Filename, Status, 결과 파일 Download 값을 확인할 수 있으며, Download 값을 확인해 보려고 했더니 추가 작업이 필요하네요. 이건 다음에 보도록 하겠습니다.